⏩️期間限定になるけどAI要約ポストを始めます.

おはようございます.期間限定になるけどAI要約ポストを始めます、なぜ期間限定になるかと言えば旧ローカルサーバーで運用しているので、無と職な期間限定のサービスになりそうリモートワークでも働くようになるとは思うものの、マシンの音がちょっとうるさいのでMTGの時に大変そうなので無と職の狭間の期間限定になりそうです.

次なる職場が高単価なお給与を支給して頂けたら、今のPCがローカルサーバーに変わる予定です.そうなれば継続して続ける可能性はあります.

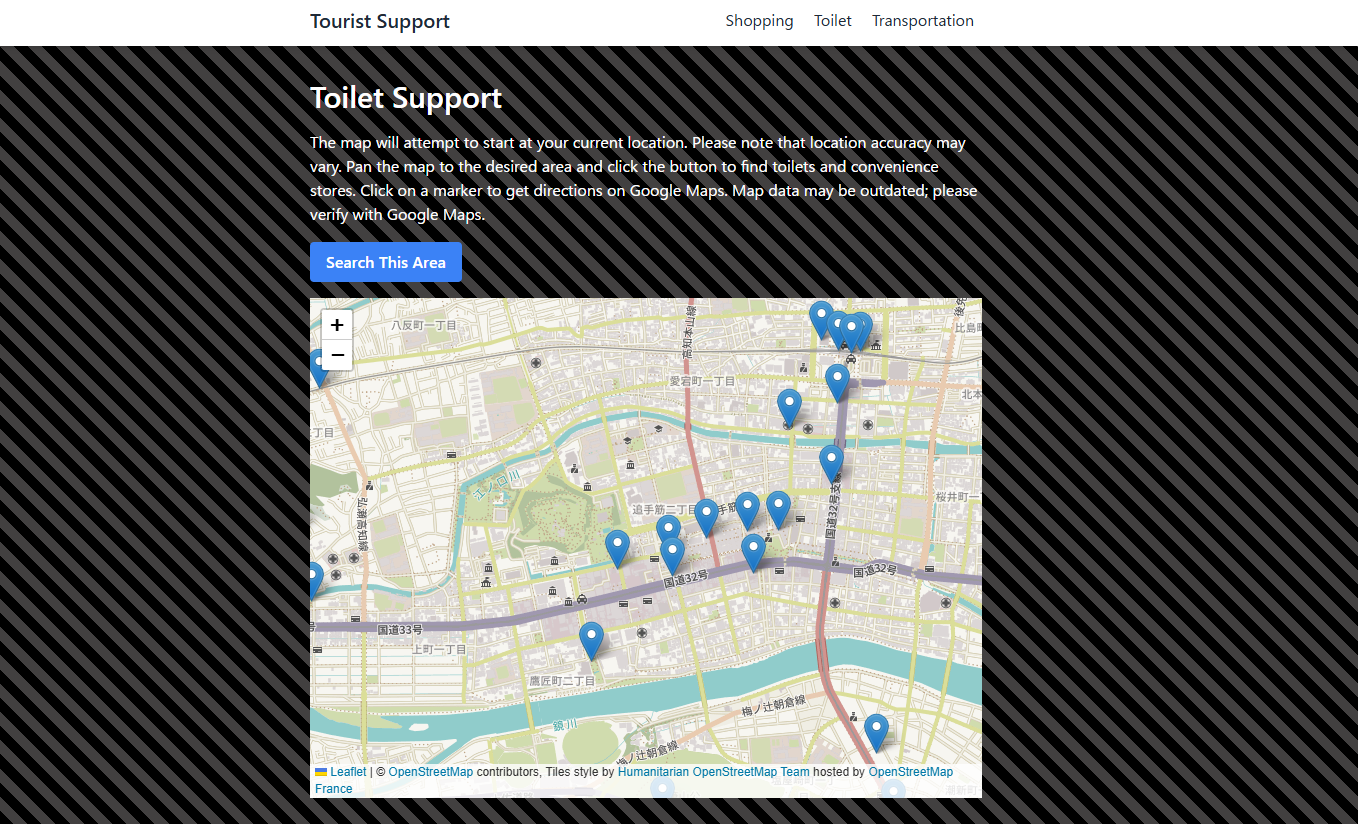

因みにAI要約ポストがどういう仕組で動いているかと言えば、ローカルサーバーからレンタルサーバーのAPIサーバーに記事の問い合わせをして記事取得し、その記事をローカルサーバーのポンコツAIが要約を行い出来上がった要約をレンタルサーバーのAPIサーバーへポストします.ポストしたデータを元にレンタルサーバーで要約もとに成形しX(旧ツイッター)にポストする形にしています.

当分の間ポンコツAIの要約ポストが続きそうです.途中でモデルの変更するつもりでいますがAIもポンコツですがパソコンもポンコツなので動くモデルが中々見つからないのが現状です.

追伸:以前はポンコツPCでAIモデルをCPUで動かしていたのですが、なんかCUDAギリ使えるみたいで今はGPUで動かしています.

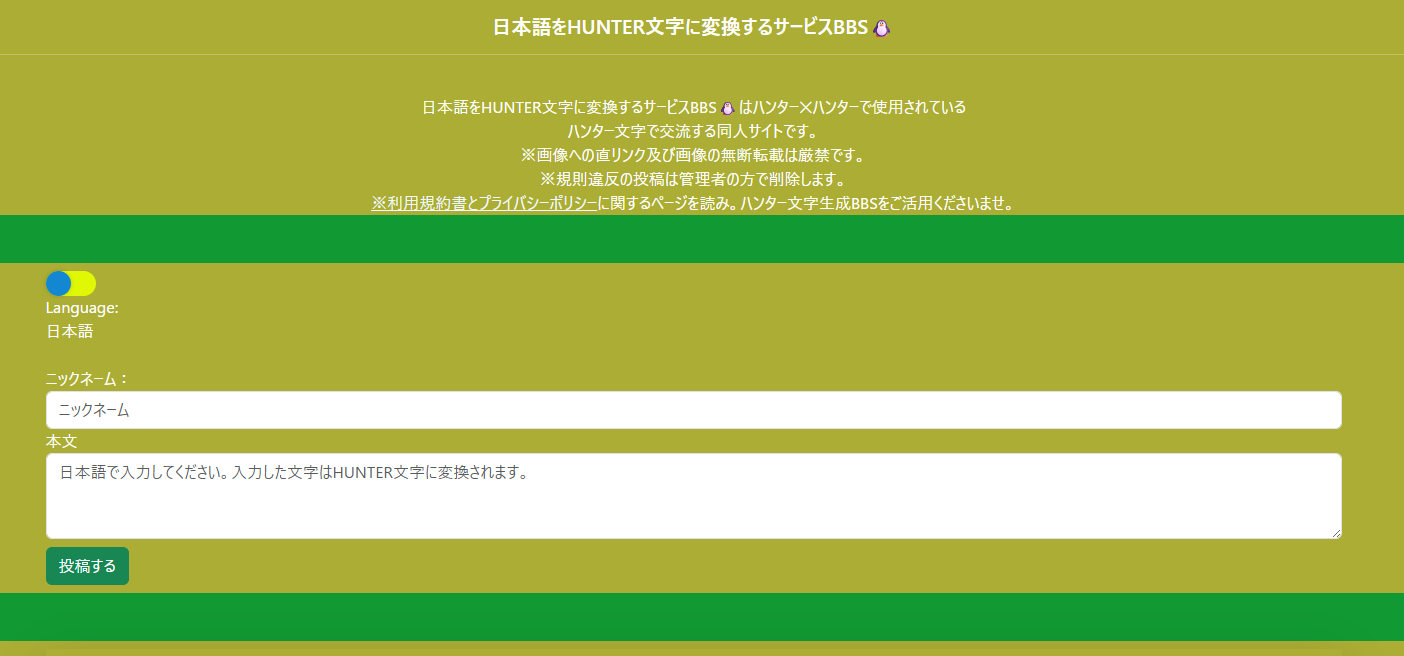

追伸:HuggingFaceTB/SmolLM3-3Bモデルは古いPCでも動くしまぁまぁ良いレスしてくれるので採用しました.

明日へ続く